Music Information Retrieval

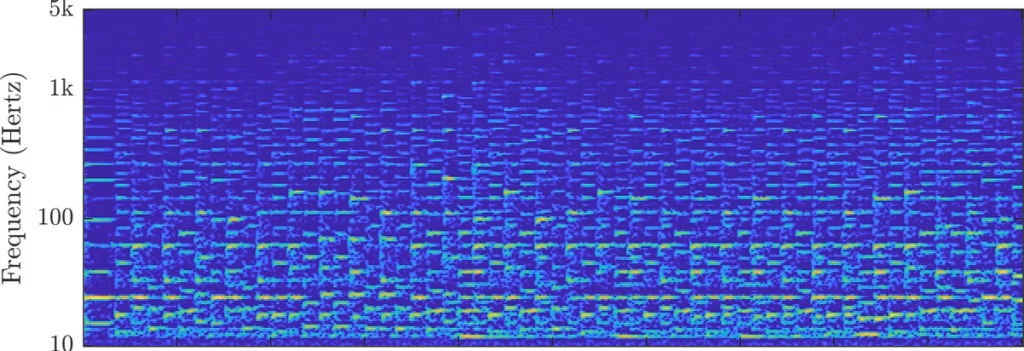

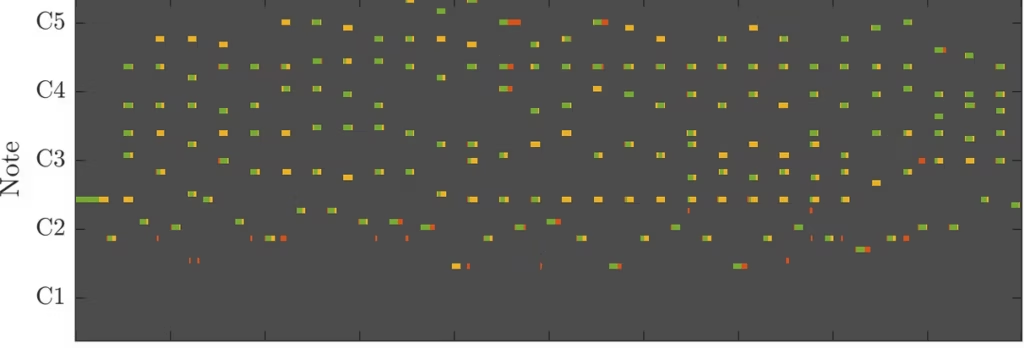

Der Forschungsbreich Music Information Retrieval (MIR) umfasst die Extraktion und Aggregation von Informationen aus musikalischen Audiodaten. MIR bezieht seine Methoden dabei aus einer Vielzahl von Disziplinen, einschließlich Psychologie, Informatik, Machine Learning und Musiktheorie. Anwendungen reichen dabei von Aufgaben zur Feature-Extraktion zur Beschreibung des Audiomaterials bis hin zur Erkennung von Eigenschaften wie Tonhöhe, Anfangszeit, Dauer und Quelle eines musikalischen Signals.

Die Forschung und Entwicklung in MIR und seinen Teilbereichen (z.B. automatische Musiktranskription, Audio-Inhaltsanalyse oder Musikgenerierung) befasst sich mit der Notwendigkeit einer intelligenten und automatisierten Verarbeitung der steigenden Zahl von öffentlichen und firmeninternen Audio- und Musikdaten, beispielsweise aus dem Internet. Die Extraktion dieser musikalischen und wahrnehmbaren Informationen aus Audiodaten hilft Menschen und Maschinen gleichermaßen auf innovative Weise mit Musik zu interagieren.

Mit unserem interdisziplinären Team sind wir in der Lage, ein breites Spektrum an MIR-bezogenen Aufgaben anzubieten. Dabei können wir den gesamten Prozess von Exploration, Analyse oder Visualisierung bis hin zur Modellbildung auf Ihren Daten anbieten.

Wir stellen das Know-How aktueller Signalverarbeitungs- und Machine-Learning-Methoden zur Verfügung, um Ihr Produkt mit Anwendungen wie automatische Musiktranskription, Quellentrennung und Instrumentenidentifikation, automatische Kategorisierung oder Empfehlungssysteme zu optimieren.